Reisebrev fra et datasenter

I disse nettsky-tider er det lett å glemme at det fortsatt er servere med prosessorer, minne, disker og nettverk som gjør vår nye hverdag mulig. Uansett om du bruker IaaS, PaaS eller SaaS så står det fortsatt en maskin der ute et sted som lagrer dataene dine og leverer tjenesten. I denne litt annerledes posten skal jeg fortelle om mitt besøk på “innsiden” av Microsoft nettskyen (forhåpentligvis uten å bryte NDAen).

Microsoft Global Foundation Services (GFS)

Microsoft har vært en nettskyleverandør siden 1997 da de kjøpte Hotmail. Siden den gang har spekteret økt betydelig og består i dag av over 200 ulike tjenester. Noen eksempler er Bing, Xbox Live, SkyDrive, Office 365 og Windows Azure. Med så mange tjenester er behovet for datakraft omfattende. Derfor har Microsoft opprettet et eget selskap med ansvar for drift av datasentrene og det verdensomspennende datanettverket. Dette selskapet er Microsoft Global Foundation Services, eller GFS. Vi hører ikke så ofte om GFS (de har ikke engang en egen artikkel på Wikipedia), men de er ledende i verden på design, bygging og drift at verdens største datasentre. GFS har blant annet vunnet flere priser for sine design.

Som navnet tilsier er GFS grunnmuren for alle Microsofts skytjenester. Det betyr at alt som er en del av Microsofts nettsky leveres fra et GFS datasenter. Det er altså ikke egne datasentre for Windows Azure eller Office 365, alle tjenester leveres fra samme fysiske bygninger. De ulike divisjonene innenfor Microsoft bestiller server, lagring og nettverkskapasitet og så bygger GFS. I skrivende stund sier GFS at de har minst 10 såkalte mega-datasentre rundt om i verden. Disse fordeles i såkalte sub-regioner. En sub-region er en begrenset fysisk lokasjon med minst ett av disse mega-datasentrene. Nøyaktig hvor datasentrene er ønsker de naturlig nok å holde hemmelig, men litt har vi fått vite:

I Europa er det to sub-regioner; en i Amsterdam, Nederland og en i Dublin, Irland. I juni 2013 var jeg på besøk ved ett av datasentrene i Dublin; DB3.

North Europe-DB3

Microsoft åpnet sitt første datasenter i Irland i 2007. Det fikk navnet DB3 og ligger sør-vest for Dublin.

Boligprisene i Irland den gangen var skyhøye så man valgte å bygge et datasenter med flere etasjer. Vanligvis finner man seg et øde område et sted og bygger en kjempebygning med én etasje, men det var ikke mulig i Dublin i 2007. Selv om man valgte å bygge opp og ikke ut kostet DB3 $500 millioner.

Sikkerheten under besøket var streng. Dette er det nærmeste det er lov å ta bilde av DB3:

Fort Knox move over…

Det først jeg la merket til da vi ankom var at bygningen var fullstendig uten navn eller logo. Rent bortsett fra at den var diger, var den fullstendig anonym. Området rundt var også helt forlatt og det var ikke et menneske å se. Jeg har tidligere arbeidet i Forsvaret og siden besøkt mange av de mest sikkerhetsbevisste bedriftene og institusjonene her i Norge, men sjelden har jeg sett fysisk sikkerhet på det nivået som her. Porten som beskytter området er den sammen som ved inngangen til den amerikanske Green Zone i Afghanistan og kan stoppe en tanks…en stor en. Anlegget er plassert i en allerede eksisterende flyforbudssone som håndheves av det irske flyvåpenet. Hele området er omgitt av gjerder og vollgraver som kan stoppe alle kjente beltekjøretøyer. De få vinduene som finnes er av skuddsikkert glass. Alle besøkende får utdelt adgangskort som endrer seg over tid. Etter hvert kommer ordet VOID frem på kortet og du vil umiddelbart blir stoppet av enhver ansatt. Skal du inn og ut av bygningen må du passere gjennom en 360-graders metalldetektor-sluse lik dem du finner på flyplasser. Mens du er i bygningen blir du til enhver tid filmet av minst to kameraer. Dørene åpnes ved hjelp av håndflategjenkjenning. Det finnes nøkler, men disse brukes bare ved spesielle anledninger og skulle en av dem komme så langt som til utsiden av porten vil det gå en alarm, fordi alle nøklene er radiomerket, og alle låsene som den nøkkelen passet i vil bli skiftet.

Vår guide fortalte at dette var et sted som var bygget for maskiner, ikke mennesker; alt handlet om funksjon, ikke form. Ikke en dråpe maling var brukt hvis det ikke tjente maskinene, det mest fargerike var klærne til de andre på turen. Det var som å være i machine city i The Matrix.

Procedures

Driftsrutinene for datasenteret var like imponerende som den fysiske sikkerheten og policyen som definerte dem er en av de viktigste delene i den totale sikkerheten. Ingen av de ansatte på datasenteret visste hva som befant seg på noe av utstyret. Ingen av dem kunne for eksempel si at dette var en Office 365 server, disk eller kabel. Det eneste de var opptatt av var om serverne var i orden og hadde korrekt driftstemperatur. De som var ansvarlige for tjeneste på sin side, for eksempel Xbox Live, befant seg helt andre steder i verden og fikk aldri lov å besøke et datasenter. Det skulle simpelt hen ikke la seg gjøre å knytte kunde, tjeneste eller data til en fysisk boks, disk eller kabel. Den kunnskapen skulle ingen ha.

Redundans

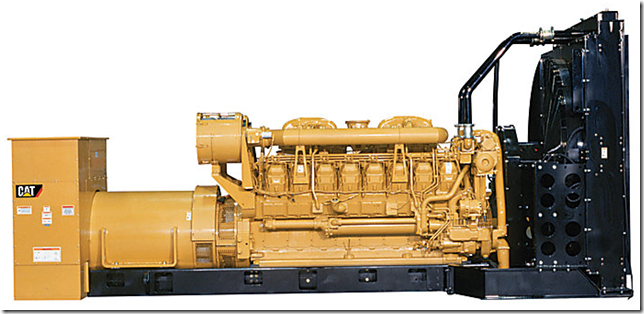

Store ressurser var brukt for å sørge for at systemene fortsatt fungerte hvis feil oppstod. Det var redundans i alle ledd. Inn til datasenteret kom det strøm fra to ulike kraftselskaper, gjennom hver sin underjordiske trasse, til hver sin ende av bygningen, helt uavhengig av hverandre. Den totale kapasiteten var på 20 MW. Skulle likevel strømmen forsvinne hadde man aggregat:

69 L, 2000 hk Caterpillar dieselaggregat, som hver produserte 2MW. Av disse hadde de 15 stk… Aggregatene ble forsynt av en egen underjordisk dieseltank og man hadde avtale med 5 forskjellig leverandører av diesel hvis man måtte går over til aggregatdrift. Det tok bare 30 minutter etter start til den første tankbilen kom. Slik fortsatte det på alle nivåer; nettverk, lagring osv. Jeg fikk fornyet tillitt til at feriebildene fra Tyrkia-ferien i 2007, som jeg hadde på SkyDrive, var trygge.

Effektivitet

I DB3 er det omtrent 400 000 fysiske servere som kjører et ukjent antall virtuelle maskiner hver. Samtidig jobbet det bare rundt 15 mennesker på hele datasenteret. Av disse arbeidet ca 2/3 enten i sikkerhetskontrollen eller drev med renhold. Altså klarte man å drifte nesten en halv million servere med en håndfull mennesker. Dette er selve definisjonen på “operational excellence”. For å kunne oppnå stordriftsfordelene som er en del av cloud-begrepet, og kunne slå konkurrentene, må man være størst og mest effektiv. Utstyr og bygninger er billig, i alle fall når du bestiller et par millioner enheter i slengen, men mennesker koster. Derfor må så mye som mulig automatiseres og effektiviseres. I GFS benytter de Microsofts egen System Center suite til dette, såvel som spesialutviklede systemer. Alt var orkestrert og overvåket.

For å holde kostnadene nede og virkelig kunne hente gevinst fra store innkjøp benyttet de kun såkalt “commodity hardware”. Altså standard maskinvare. Ingen spesialisert hardware. Microsoft er jo et software-selskap så de ønsket å gjør alt med software. Derfor har de designet sin egen servermodell. Denne har de tatt bort alt overflødig fra, alt som kan bruker unødvendig strøm, og stappet den så full av CPU, minne og nettverkskontrollere som mulig. Så har de gitt tegningene til DELL eller HP og bedt dem levere noen millioner. På denne måten får de lav stykkpris, en utrolig høy tetthet i datahallene og kan bruke én servermodell til alt. I Windows Azure for eksempel, kjører Windows Server med Hyper-V direkte på den fysiske maskinvaren og virtuelle maskiner levere alle tjenester; IaaS VMer, PaaS VMer, lagring, lastbalanserere, brannmurer og alt det andre. Oppgradering av hardware gjøres ved å flytte disse VMene over på neste generasjons server.

Miljø

Ved å effektivisere ønsker ikke Microsoft bare å spare penger, men også miljøet. Mye arbeide hadde gått med til å lage miljøvennlige løsninger. Feks ønsket man at alt materiell som ble levert til datasenteret skulle kunne resirkuleres eller gjenbrukes, inkludert emballasjen det kom i. Dette var et absolutt krav til leverandørene. Det eneste som ikke ble resirkulert var harddisker. Disse ble destruert på stedet når de av en eller annen grunn ikke skulle benyttes lenger. Som vår guide sa “disks arrive at the datacenter, but they never leave”. Litt som Hotel California altså…

Plasseringen av selve datasenteret var også gjort med tanke på miljøet, klimaet i Dublin er nemlig slik at de kan kjøle hele anlegget kun med utendørsluft og såkalte absorpsjonskjølere. Da DB3 ble bygget installerte man faktisk vanlige aircondition anlegg, men disse ha ble aldri benyttet og er derfor blitt demontert. I tillegg er all strøm som benyttes produsert med vannkraft.

PUE

Alle datasenter ønsker en så lav Power Usage Effectiveness (PUE) som mulig. PUE får man ved å dele den totale energien som datasenteret benytter på den energien som IT benytter. IT i denne sammenhengen betyr det som står bak tjenesten du leverer. Man ønsker en PUE så nær 1.0 som mulig, selv om negativ, eller <1.0, er mulig.

DB3 har en PUE på ca 1.15, men Microsoft er kommet mye lengre og ser for seg en PUE i de nyeste datasentrene på ned mot 1.05.

DB3, DB4, DB5, DB6, DB7 and counting…

Da vi besøkte DB3 opererte det allerede på maks kapasitet. Det samme gjorde det nyere DB4 som lå vegg i vegg. Det nye DB5, som var under bygging noen meter bortenfor, og dobbelt så stort som DB3 og DB4 tilsammen, var allerede logisk fult; all tilgjengelig kapasitet var allerede beslaglagt av planlagte tjenester. DB6 og DB7 var på planleggingsstadiet. Ikke rart at Microsoft fortsatt er en av verdens største kjøpere av servere…

Ved reisens slutt…

Vi oppholdt oss i datasentret i ca. tre timer, men det var en helt utrolig opplevelse. En tidligere besøkende hadde oppsummert det hele som “hardware pornography”, og det er jeg hjertens enig i. Etter besøket og all teknologien og alle statistikkene var det tid for litt kultur…

Hvis du selv har lyst til å se hvordan et Microsoft datasenter ser ut på innsiden kan du sjekke følgende video: