Azure Data Lake と Azure Data Factory を使用してビッグ データ パイプラインを作成する

このポストは、10 月 6 日に投稿された Create big data pipelines using Azure Data Lake and Azure Data Factory の翻訳です。

このたびマイクロソフトは、拡張された新しい Azure Data Lake を発表しました (英語)。拡張された Azure Data Lake には Azure Data Lake Store、Azure Data Lake Analytics、Azure HDInsight が含まれており、ビッグ データの処理と分析がより簡単になり、アクセス性も向上します。

Azure Data Lake Store は、サイズや種類を問わずさまざまなデータを簡単に取得し、あらゆるスケールのデータをアプリケーションを変更することなく高速で処理することが可能な単一のリポジトリです。Azure Data Lake Analytics は Apache YARN を基盤として構築された、U-SQL 言語対応の新しいサービスであり、お客様の強力なコードと SQL のメリットを統合することができます。また、このサービスでは動的にスケール変更するため、ビジネス目標の達成に集中することができます。さらに、Azure Active Directory を使用して企業レベルのセキュリティを保ちつつ、あらゆる種類のデータを分析することができます。

Azure Data Factory では、従来からサポートされていた Azure HDInsight に加えて、Azure Data Lake Store および Azure Data Lake Analytics も使用してビッグ データ パイプラインを作成できます。この機能は、Azure Data Lake Store と Azure Data Lake Analytics がリリースされると (今年中にプレビューをリリース予定) Azure Data Factory でも使用できるようになります。以下では、Azure Data Lake で新たにできるようになったことをご紹介します。

Azure Data Lake Store でデータの送信元と送信先として使用可能なサービス

下記のソースから Azure Data Lake Store へデータを移動することができます。

- Azure Blob

- Azure SQL Database

- Azure Table

- オンプレミスの SQL Server データベース

- Azure DocumentDB

- Azure SQL DW

- オンプレミスのファイル システム

- オンプレミスの Oracle Database

- オンプレミスの MYSQL データベース

- オンプレミスの DB2 データベース

- オンプレミスの Teradata データベース

- オンプレミスの Sybase データベース

- オンプレミスの PostgreSQL データベース

- オンプレミスの HDFS

- 一般的な OData

- 一般的な ODBC

また、Azure Blob、Azure SQL Database、オンプレミスのファイル システムなど、Azure Data Lake Store からさまざまな送信先にデータを移動できます。

対応するデータ ソースは今後も毎月拡大される予定です。

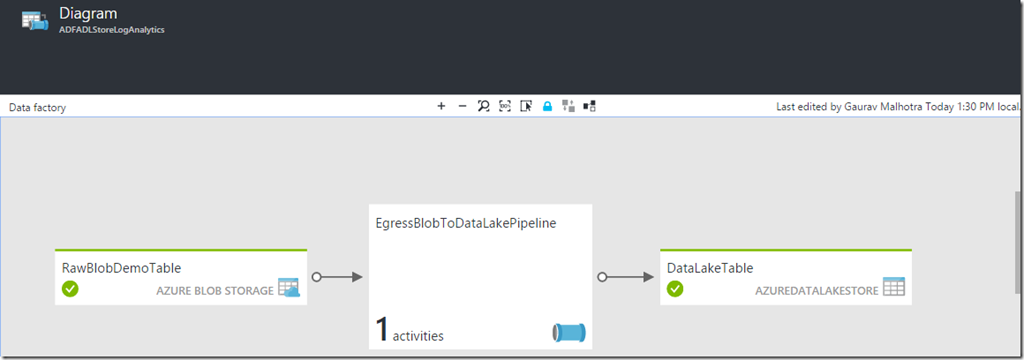

以下のパイプラインは、Azure Data Factory でコピー操作で Azure Blob ストレージから Azure Data Lake Store にデータを移動する場合を示したものです。

ADF で E2E のビッグ データ パイプラインを作成し Azure Data Lake Analytics サービスで U-SQL スクリプトを実行

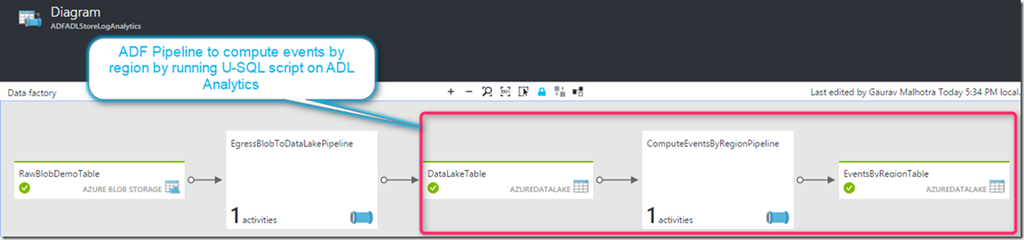

ログの処理は、さまざまな業種 (小売、金融、ゲームなど) で一般的に行われています。下の E2E のビッグ データ ワークフロー図は、次のプロセスを表しています。

- ADF パイプラインでログ データを Azure Blob ストレージから Azure Data Lake Store に移動する。

- 前の手順で Azure Data Lake Store アカウントにコピーされたログを ADF パイプラインが取得し、U-SQL スクリプトを Azure Data Lake Analytics で処理段階の 1 つとして実行してログを処理する。この U-SQL スクリプトではリージョンごとにイベントの演算処理を実行し、結果を下流工程で使用します。

このように、Azure Data Factory を使用して E2E のビッグ データ パイプラインを作成することが可能で、またこのパイプラインではさまざまなデータ ソースから Azure Data Lake Store に、またはその逆にデータを移動することができます。さらに、Azure Data Lake Analytics で処理段階の 1 つとして U-SQL スクリプトを実行したり、ニーズに応じてスケールを動的に変更したりできます。マイクロソフトでは、ビッグ データ処理および分析のワークフローを向上させるソリューション開発を今後も継続的に進めていきます。

マイクロソフト クラウド プラットフォーム チームによる Microsoft Azure Data Lake の詳細については、こちらのページ (英語) をご覧ください。また、こちらのビデオ (英語) では、Azure Data Factory でパイプラインを作成する方法や Data Factory の使用方法を説明しています。Data Factory に関するご意見や新機能のご要望がありましたら、ぜひ Azure Data Factory フォーラム (英語) まで投稿してください。